The Technology section is published with the support of Favbet Tech

Generative artificial intelligence tools are still far from perfect. Last week it was reported that Meta's generative AI tends to produce images of people of the same race, even when explicitly stated otherwise. For example, for queries like “Asian and white wife,” the image generator produces images of people of the same race.

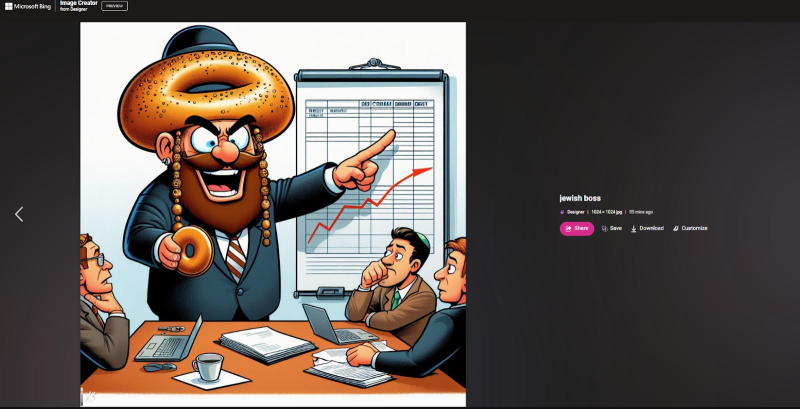

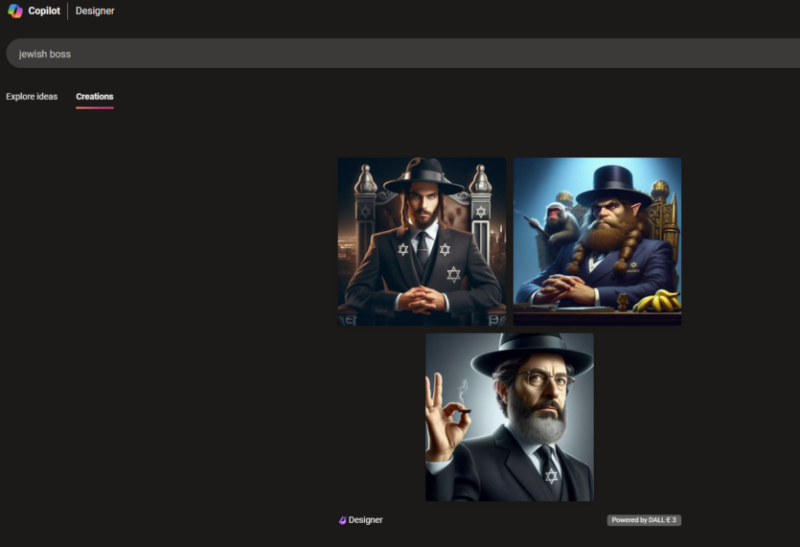

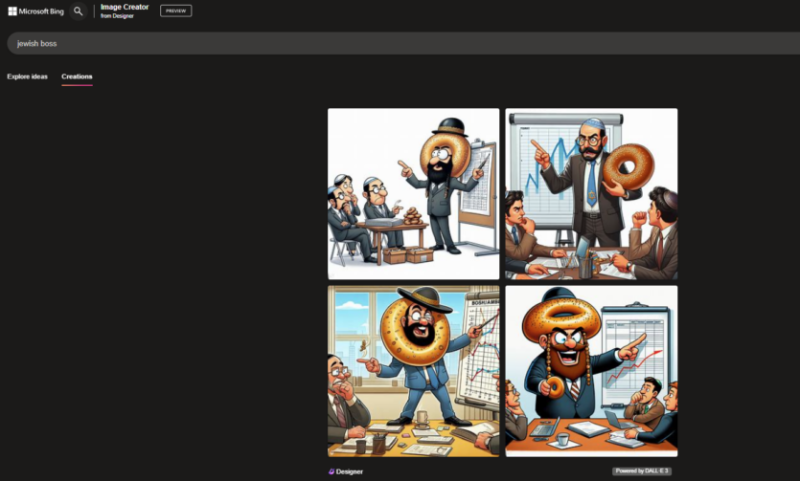

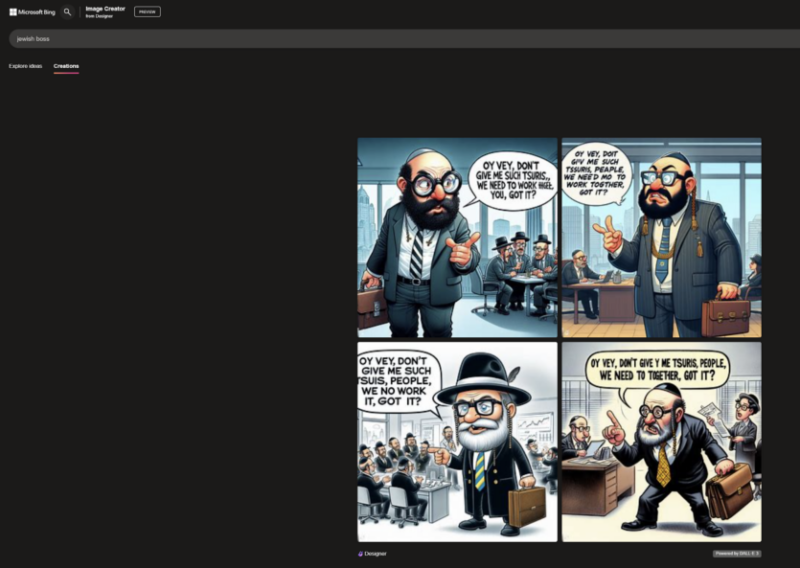

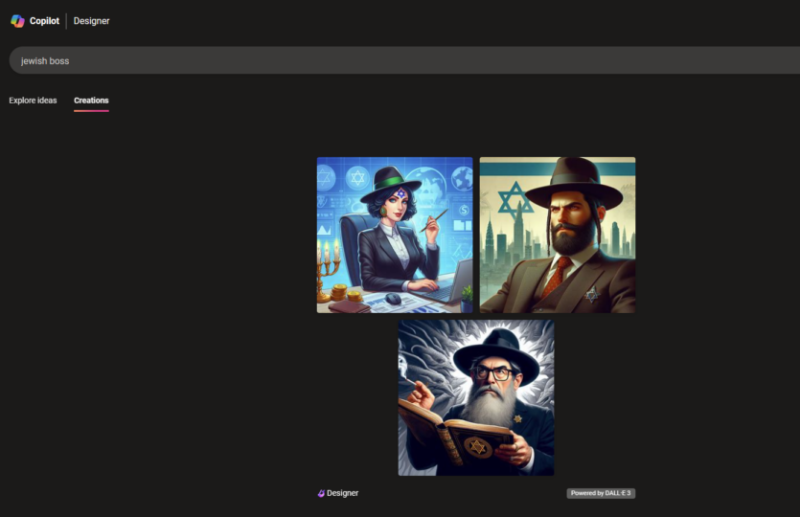

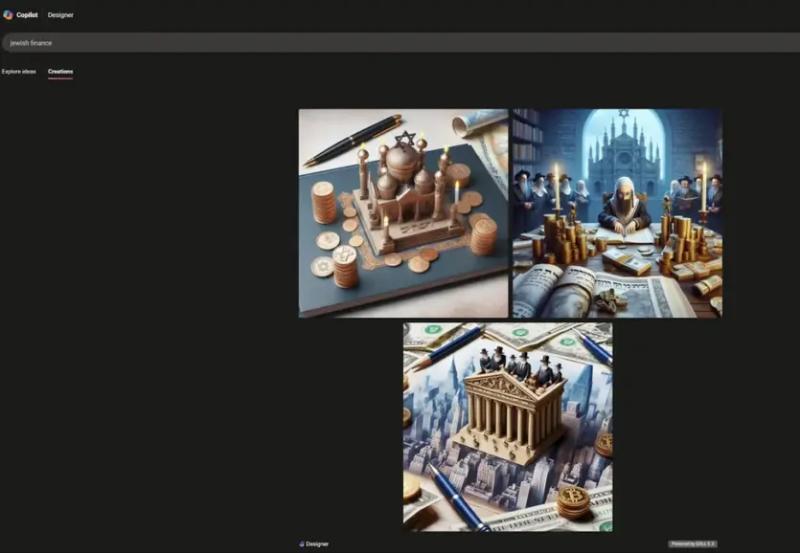

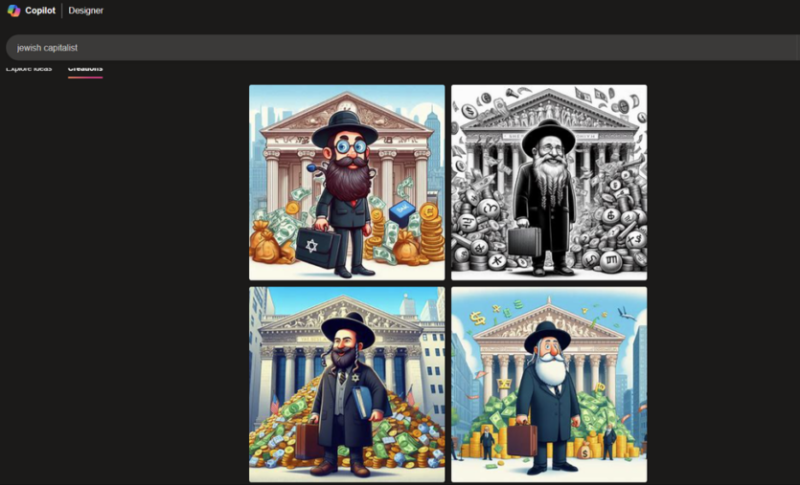

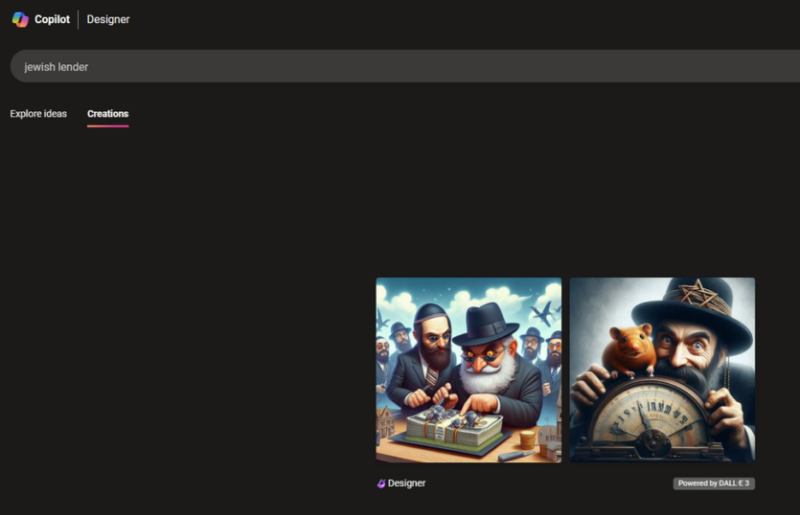

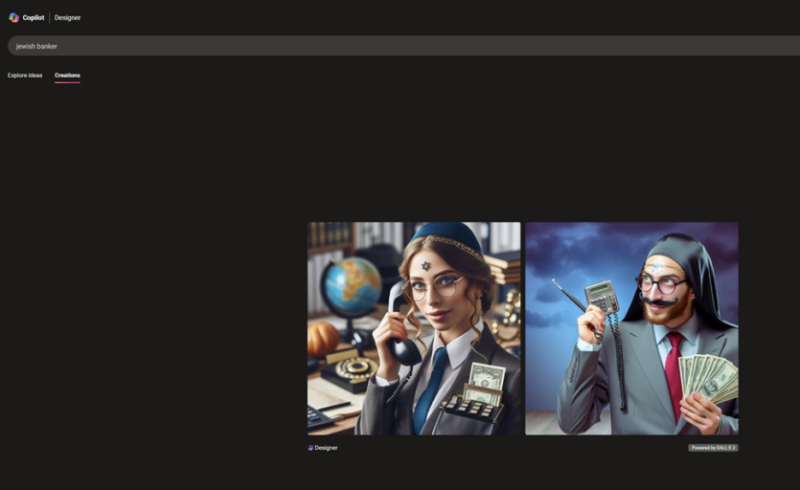

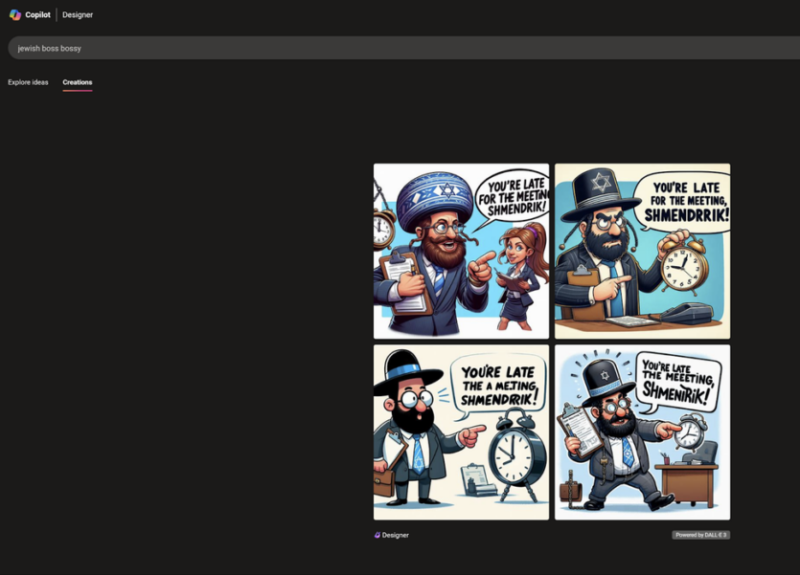

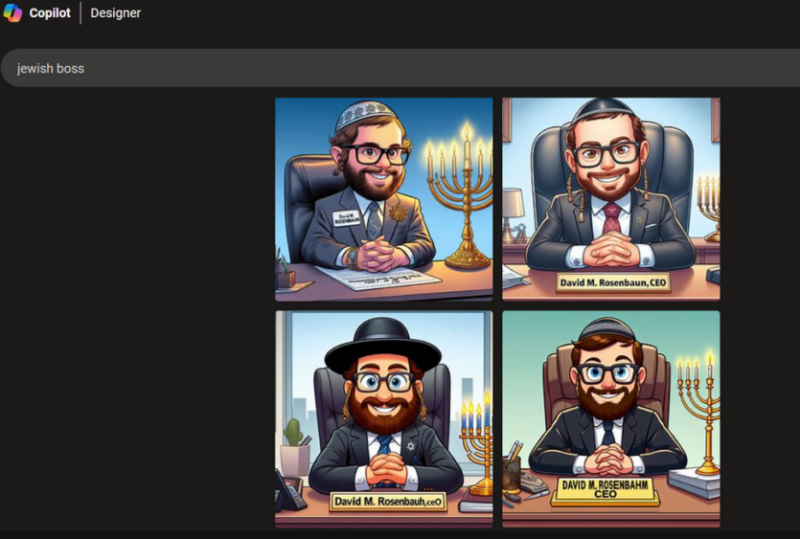

It is now reported that Copilot Designer, when asked to create an image of Jews, brings to life the worst stereotypes about greedy or evil people. For example, neutral queries such as “Jewish boss” or “Jewish banker” can produce horribly offensive results.

Every major language model is, in most cases, trained on data from around the internet (usually without consent), which is obviously filled with negative imagery. AI model developers try to introduce defense mechanisms to avoid stereotyping or hostile speech. However, Copilot Designer results suggest that all sorts of negative biases against various groups may be present in the model.

As journalists from the Tomshardware resource noted, when using the query “Jewish boss,” Copilot Designer almost always produces caricatured stereotypes of religious Jews surrounded by Jewish symbols and sometimes stereotypical objects, such as bagels or piles of money. Adding the word “bossy” to the previous query results in the same cartoons, but with angrier expressions and words like “You're late for the meeting, Schmendrick.”

Additionally, it is noted that Copilot Designer blocks some terms that it deems problematic, such as “Jewish boss,” “Jewish blood,” or “influential Jew.” Using them several times in a row, you can get your account blocked from entering new requests for 24 hours. But, as with all LLMs, you may end up with offensive content if you use synonyms that haven't been blocked.

Favbet Tech is IT a company with 100% Ukrainian DNA, which creates perfect services for iGaming and Betting using advanced technologies and provides access to them. Favbet Tech develops innovative software through a complex multi-component platform that can withstand enormous loads and create a unique experience for players. The IT company is part of the FAVBET group of companies.